在数字化时代,数据处理服务是服务器承担的核心使命之一。本文将系统性地汇总与解析服务器在数据处理服务方面的基础知识,涵盖其定义、核心组件、处理流程、服务类型及关键技术,旨在为读者构建一个清晰完整的认知框架。

一、 数据处理服务的定义与重要性

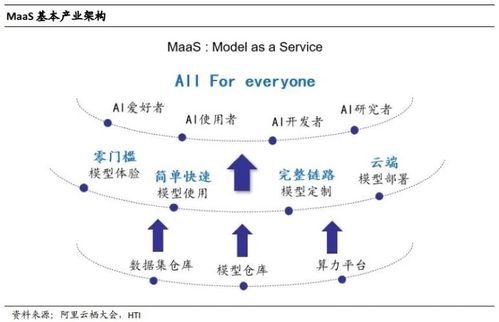

数据处理服务,指的是服务器接收、存储、计算、分析并最终输出数据,以支撑上层应用和业务需求的一系列功能。它是信息系统的“心脏”,将原始数据转化为有价值的信息和知识。从企业ERP系统到互联网社交平台,从科学计算到人工智能模型训练,无一不依赖于强大、可靠的数据处理服务。其性能、稳定性和安全性直接关系到整个业务的连续性与竞争力。

二、 服务器数据处理的核心硬件组件

- 中央处理器(CPU):服务器的“大脑”,负责执行指令和处理数据。多核、高主频、大缓存的CPU能显著提升并行计算和复杂事务处理能力。

- 内存(RAM):作为CPU的“工作台”,临时存储正在处理的数据和指令。容量与速度(频率)决定了服务器同时处理任务的能力和数据吞吐速度。

- 存储系统:数据的永久或长期存放地,包括硬盘驱动器(HDD)、固态硬盘(SSD)以及更高速的NVMe SSD。存储的IOPS(每秒输入输出操作次数)和吞吐量是关键性能指标。

- 网络接口卡(NIC):服务器与外部网络通信的桥梁,其带宽(如1GbE, 10GbE, 25GbE等)和性能直接影响数据输入输出的效率。

三、 数据处理的基本流程

一个典型的数据处理流程通常遵循以下步骤:

- 数据摄入:通过网络或本地接口接收原始数据流或批量数据。

- 数据存储:将数据持久化写入存储系统,可能涉及缓存、数据库或文件系统。

- 数据处理/计算:CPU和内存协同工作,执行预定的算法、逻辑或查询(如数据清洗、转换、聚合、分析、模型推理等)。

- 结果输出:将处理后的结果返回给客户端应用程序、存储到新位置或触发后续操作。

四、 主要数据处理服务类型

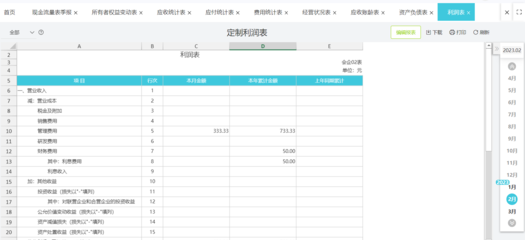

- 在线事务处理(OLTP):专注于高并发、短周期、原子性的日常业务操作(如订单录入、银行转账)。要求极高的IOPS和事务一致性,常用关系型数据库(如MySQL, PostgreSQL)支撑。

- 在线分析处理(OLAP):专注于对海量历史数据进行复杂的查询和分析,以支持决策。侧重吞吐量和复杂计算能力,常用数据仓库或列式数据库(如ClickHouse, Amazon Redshift)。

- 批处理服务:在特定时间窗口对大量数据进行离线处理(如日志分析、月度报表生成)。对延迟不敏感,但要求强大的计算和I/O资源。Hadoop/Spark是典型框架。

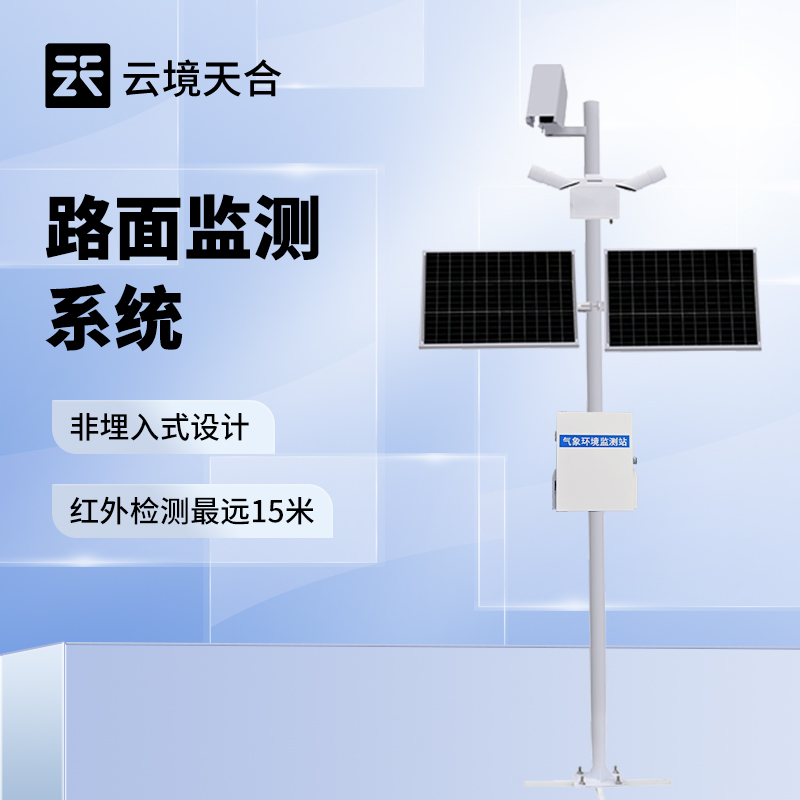

- 流处理服务:对连续不断的数据流进行实时或近实时处理(如实时监控、欺诈检测)。要求低延迟和高吞吐,常用Flink, Storm, Kafka Streams等框架。

五、 关键软件与技术栈

- 操作系统:如Linux发行版(CentOS, Ubuntu Server)或Windows Server,提供基础运行环境与资源管理。

- 数据库管理系统(DBMS):数据处理的核心软件,负责数据的组织、存储、检索和管理。

- 中间件与运行时环境:如Web服务器(Nginx, Apache)、应用服务器(Tomcat)及各种语言运行时(JVM, .NET CLR, Python),为数据处理应用提供运行平台。

- 虚拟化与容器化:通过虚拟机(VM)或容器(Docker/Kubernetes)实现资源隔离、灵活调度与快速部署,提升服务器资源利用率和数据处理服务的敏捷性。

- 分布式计算框架:用于处理超出单台服务器能力的数据集,将任务分解到集群中并行执行(如Hadoop, Spark)。

六、 性能考量与优化方向

- 性能指标:关注吞吐量、响应时间(延迟)、并发处理能力及资源利用率(CPU、内存、磁盘、网络)。

- 优化策略:包括硬件升级(如使用SSD、增加内存)、软件调优(数据库索引、查询优化)、架构优化(读写分离、缓存引入、负载均衡)以及算法改进。

七、 安全与可靠性保障

数据处理服务必须确保:

- 数据安全:通过加密(传输中与静态)、访问控制、防火墙等手段保护数据免遭泄露与篡改。

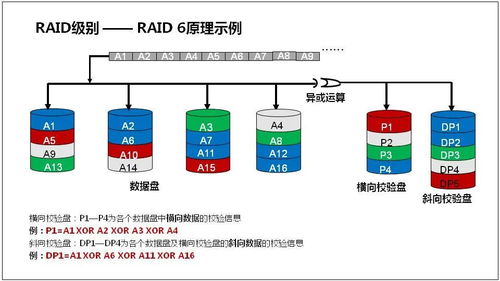

- 服务可靠:通过冗余设计(RAID、集群、异地容灾)、定期备份以及完善的监控告警体系,保障服务高可用与数据持久性。

服务器作为数据处理服务的物理载体,其效能是硬件能力、软件架构与运维管理的综合体现。深入理解这些基础知识,是规划、部署和优化任何依赖于数据处理的应用系统的基石。随着云计算和边缘计算的发展,数据处理服务正变得更加弹性、分布式和智能化,但其核心原理与追求高效、可靠、安全的目标始终不变。